L’uso dell’A.I. che non mette a rischio dati e privacy

«Mi aiuto con l’intelligenza artificiale per le parti più ripetitive: così posso dedicare più tempo alle persone».

È una frase che oggi si sente sempre più spesso nelle strutture socio sanitarie.

L’A.I. sta diventando un aiuto concreto nel lavoro quotidiano: dalla dettatura vocale alla ricerca intelligente nei documenti, dall’analisi dei report fino alla categorizzazione automatica delle attività.

Questi ultimi sono strumenti potenti, che promettono di semplificare il lavoro, migliorare la qualità dei dati e restituire tempo alla relazione di cura. Ma proprio perché operano su informazioni sensibili, è fondamentale usarli con metodo, consapevolezza e responsabilità.

Questa guida è pensata per operatori, coordinatori e responsabili di struttura che vogliono:

- usare strumenti dotati di A.I. in modo sereno,

- rispettare la normativa sulla protezione dei dati,

- ridurre i rischi privacy,

- ottenere risultati affidabili e di qualità.

Se vuoi approfondire il tema della sicurezza dei dati nella pratica quotidiana, puoi leggere anche “Proteggi i dati, semplifica il lavoro: 10 regole d’oro per i tuoi operatori”, dedicato alle buone abitudini operative per lavorare in modo più sicuro.

In sintesi

5 regole d’oro per usare l’A.I. in serenità

- Inserisci solo i dati davvero necessari.

- Verifica sempre i risultati prima di usarli.

- Evita riferimenti diretti a persone identificabili.

- Proteggi credenziali e accessi.

- In caso di dubbi o anomalie, segnala subito.

Perché serve una guida sull’intelligenza artificiale nel socio sanitario

Nel settore socio sanitario i dati non sono mai “solo dati”.

Parliamo di informazioni sanitarie, sociali, familiari, relazionali: elementi che raccontano la vita delle persone assistite.

L’A.I. può aiutare molto, ma:

- non sostituisce il giudizio umano,

- non è infallibile,

- non solleva dalle responsabilità legali e professionali.

Le principali autorità europee e italiane (Commissione Europea, Garante Privacy, regolamento europeo sull’AI – AI Act) concordano su alcuni principi chiave per l’uso dell’intelligenza artificiale in sanità:

- centralità della persona,

- minimizzazione dei dati,

- trasparenza,

- sicurezza,

- responsabilità umana.

Tradotti nella pratica quotidiana: usare l’A.I. sì, ma con regole chiare.

Se desideri invece approfondire il tema dei consensi puoi leggere l’articolo dedicato alla “gestione della privacy in RSA“.

Che tipo di strumenti A.I. si usano oggi nelle strutture

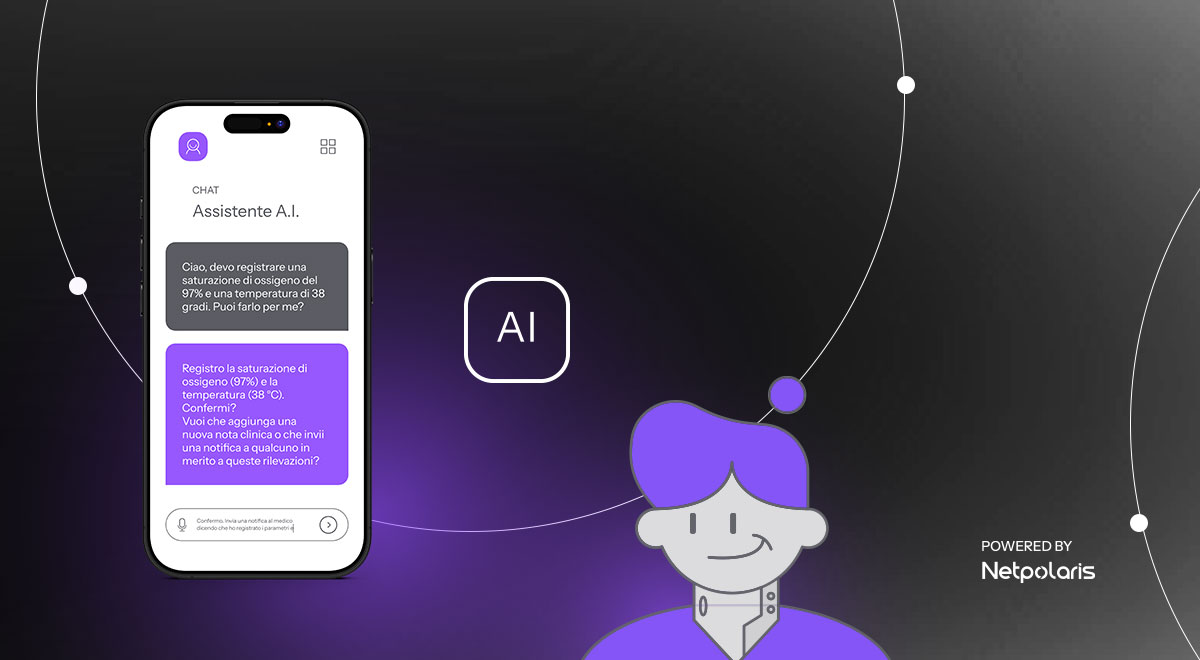

Nei software gestionali socio sanitari l’A.I. è già presente sotto diverse forme:

- assistenti digitali per il supporto operativo,

- categorizzazione automatica delle consegne del diario,

- estrazione intelligente di dati dai report,

- dettatura vocale,

- digitalizzazione dei referti cartacei,

- ricerca intelligente nei documenti.

In Netpolaris l’A.I. è stata introdotta proprio per svolgere queste funzioni ed è utilizzata con questo obiettivo:

semplificare il lavoro quotidiano, migliorare la qualità dei dati e lasciare più spazio alla relazione e alla cura, con particolare attenzione a sicurezza, conformità normativa e tutela della privacy.

Qualunque sia il fornitore del software, i principi di utilizzo corretto restano gli stessi.

Decalogo per il Trattamento dati A.I. in sicurezza nei software

Di seguito proponiamo una versione semplice e operativa delle principali regole per usare le funzionalità di intelligenza artificiale in modo sicuro e responsabile, pensata per ridurre i rischi per la privacy e garantire la qualità dei risultati nel lavoro quotidiano degli operatori.

01) Principio di necessità e minimizzazione

- Inserisci solo le informazioni strettamente necessarie alla richiesta.

- Evita dati eccedenti o non indispensabili.

- Nelle chat A.I. usa pseudonimi quando possibile.

Meno dati inutili inserisci, minore è il rischio. Sempre nel rispetto dei consensi degli ospiti.

02) Caricamento e classificazione dei documenti

- Carica solo documenti conformi alle policy interne.

- Se il documento contiene dati particolari o sensibili, valuta la pseudonimizzazione prima del caricamento.

03) Uso di chat con “assistente A.I.”

- I messaggi possono essere elaborati da servizi esterni.

- Non inserire dati eccedenti o non indispensabili.

- Evita riferimenti diretti a persone identificabili.

04) Audio e trascrizioni

- Parla in modo chiaro.

- Non includere dati sensibili se non strettamente necessari.

- Ricontrolla sempre il testo trascritto.

05) Verifica dei risultati

- Controlla sempre estrazioni, sintesi e suggerimenti.

- Non usare mai l’output dell’A.I. “alla cieca”.

- Segnala errori per migliorare i modelli interni.

L’A.I. aiuta, ma la responsabilità resta umana.

06) Sicurezza e accessi

- Usa solo le tue credenziali personali.

- Non condividerle con colleghi.

- Esci dal sistema quando non lo usi.

07) Gestione degli incidenti

- In caso di sospetto data breach o output anomali segnala subito al referente privacy aziendale.

08) Conservazione e cancellazione

- Rispetta le politiche di retention.

- Evita archivi locali non autorizzati.

- Non esportare dati inutilmente.

09) Formazione e aggiornamenti

- Partecipa alle sessioni formative.

- Consulta gli aggiornamenti disponibili.

Alcuni falsi miti da sfatare nell’uso dell’AI

“L’A.I. è autonoma e decide da sola”

No. L’A.I. fornisce suggerimenti o output. La decisione finale spetta sempre all’operatore.

“Se lo fa il software, è automaticamente conforme”

No. La conformità dipende anche da come lo strumento viene usato.

“È solo un supporto tecnico, non tocca la privacy”

Falso. Ogni dato inserito è un trattamento di dati personali.

Esempio pratico di rispetto dei dati nell’uso dell’A.I.

Cosa scrivere (e cosa no) in una chat A.I.

Scenario corretto

“Riassumi i punti principali dell’ultima valutazione multidimensionale dell’ospite Rossi, concentrandoti su autonomia e bisogni assistenziali.”

Scenario da evitare

“Riassumi la cartella clinica completa di Mario Rossi, nato il 12/03/1941, con diagnosi di Alzheimer e diabete, che vive in via…”

Perché?

Nel primo caso la richiesta è mirata, proporzionata e minimizzata. Nel secondo vengono inseriti dati identificativi e sanitari eccedenti e non necessari.

Cosa dicono le linee guida ufficiali (in breve)

Senza entrare in tecnicismi giuridici, i principali documenti europei e italiani sull’uso dell’AI in sanità – in particolare il Regolamento UE 2024/1689 (AI Act), le linee guida UE su eHealth e intelligenza artificiale, e i documenti del Garante per la protezione dei dati personali – ribadiscono alcuni concetti molto concreti, che hanno anche valore operativo per le strutture:

- l’AI deve essere a supporto del professionista e non può sostituire il giudizio umano;

- i dati sanitari rientrano tra le categorie particolari di dati e richiedono tutele rafforzate;

- va rispettato il principio di minimizzazione: trattare solo i dati necessari;

- devono esserci misure tecniche e organizzative adeguate;

- è sempre necessaria una supervisione umana significativa sugli output dell’AI;

- serve trasparenza verso operatori e pazienti sull’uso di sistemi automatizzati.

Checklist rapida per gli operatori (da stampare) mentre usano i tool A.I.

Prima di usare una funzione A.I., chiediti:

- Sto inserendo solo i dati davvero necessari?

- Posso evitare nomi, date di nascita o altri identificativi diretti?

- Il documento che sto caricando è conforme alle policy interne?

- Ho verificato che l’output dell’AI sia corretto e coerente?

- Sto usando le mie credenziali personali?

- Sto evitando di esportare o salvare dati inutilmente?

- In caso di dubbio, so a chi segnalarlo?

- Ho controllato se esistono istruzioni aggiornate su questo strumento?

Bastano 30 secondi per ridurre drasticamente il rischio.

Quando non usare l’A.I.: 3 casi concreti

- Quando servono decisioni cliniche o assistenziali delicate

L’A.I. può aiutare a riassumere dati o trovare informazioni, ma non deve mai essere usata per prendere decisioni cliniche, valutazioni diagnostiche o scelte assistenziali complesse. - Quando non è necessario trattare dati personali

Se puoi ottenere lo stesso risultato senza inserire dati reali (es. usando esempi generici), fallo. - Quando non sei sicuro del contesto o della finalità

Se non è chiaro perché stai usando l’A.I. o che uso verrà fatto dell’output, è meglio non usarla.

Il ruolo delle strutture (non solo degli operatori)

Per un uso davvero corretto dell’A.I. servono anche:

- policy interne chiare,

- formazione continua,

- referenti privacy identificati,

- audit periodici,

- strumenti progettati secondo il principio di privacy by design.

In Netpolaris l’A.I. è integrata nei software con un principio guida chiaro:

innovare sì, ma mettendo al centro le persone, la qualità delle cure e la tutela dei dati.

Per questo:

- le funzionalità A.I. sono progettate per essere trasparenti,

- l’uso dei dati è regolato da consensi chiari,

- l’addestramento dei modelli è controllato,

- la sicurezza è parte del progetto, non un’aggiunta.

Lo stesso approccio guida anche lo sviluppo aziendale degli strumenti A.I.: assistente operativo, dettatura vocale, ricerca intelligente, digitalizzazione dei referti, estrazione e categorizzazione automatica dei dati.

L’obiettivo non è “aggiungere A.I.”, ma semplificare il lavoro quotidiano, migliorare la qualità dei dati e lasciare più spazio alla relazione e alla cura, in modo conforme, sicuro e trasparente.

In conclusione: dati sanitari e utilizzo dell’AI

L’Intelligenza Artificiale può diventare un alleato prezioso nel lavoro socio sanitario. Solo se:

- viene usata con criterio,

- si rispettano regole chiare,

- si mantiene sempre il controllo umano.

Tecnologia e umanità non sono in contraddizione. Se ben governata, l’A.I. può davvero aiutare a prendersi cura meglio.

Contattaci per richiedere la demo gratuita dei nostri software.

Fonti e documenti di riferimento

Per chi desidera approfondire in modo più tecnico o normativo, ecco una selezione ordinata delle principali fonti ufficiali e divulgative sull’uso dell’AI in sanità e nel trattamento dei dati.

Normativa e linee guida europee

- Regolamento UE 2024/1689 – AI Act (testo ufficiale in italiano) Quadro normativo europeo sull’uso dell’intelligenza artificiale, con regole specifiche per i sistemi ad alto rischio, inclusi quelli in ambito sanitario.

- Commissione Europea – AI in sanità ed eHealth Pagina ufficiale UE su intelligenza artificiale, sanità digitale ed eHealth.

- Quadro normativo europeo sull’AI – Digital Strategy Sezione di sintesi della strategia UE sull’intelligenza artificiale e sull’AI Act.

Normativa e documenti italiani (protezione dei dati)

- Regolamento UE 2016/679 – GDPR (pagina Garante Privacy) Testo e risorse ufficiali sul Regolamento generale sulla protezione dei dati.

- Garante Privacy – AI e dati personali in ambito sanitario / Decalogo per i servizi sanitari Documento del Garante per la protezione dei dati personali che fornisce indicazioni operative sul trattamento dei dati sanitari con sistemi di intelligenza artificiale e un decalogo di principi per la realizzazione di servizi sanitari basati su AI

Approfondimenti divulgativi e formativi

- Agenda Digitale – Uso dell’IA in sanità: principi, privacy e responsabilità Articolo di sintesi sui principali profili giuridici e organizzativi dell’AI in sanità.

- ENERI – AI in healthcare: technology basics (versione italiana) Documento introduttivo sugli aspetti tecnologici di base dell’AI applicata alla sanità.